type

Post

status

Published

date

Jul 14, 2025

slug

summary

本文深入解析Netty 4.1.x核心源码,揭示其高性能网络编程的实现原理。主要内容包括:1.启动流程分析:详细拆解ServerBootstrap初始化、Channel注册及端口绑定过程,展现主从Reactor模型的实现;2.线程模型剖析:深入EventLoop工作机制,包括事件循环、任务队列及JDK空轮询修复等关键技术;3.数据读写全链路:从客户端发送到服务端处理的完整流程,涵盖粘包拆包、编解码等核心环节;4.设计模式应用:责任链模式在ChannelPipeline中的实现,以及事件驱动模型的异步处理机制;5.性能优化细节:包括内存管理、零拷贝、线程模型优化等关键技术。文章通过时序图、场景分析和源码解读,为开发者提供Netty深度使用指南和架构设计参考。

tags

响应式

异步编程

Netty

NIO

category

学习思考

icon

password

musicId

catalog

archives

sort

前言:为何要深入Netty源码?

Netty作为Java领域高性能网络编程的事实标准,其设计思想与实现细节堪称异步非阻塞IO的典范。前文我们已了解Netty的基本模型、核心组件及HelloWorld案例,但要真正掌握Netty的精髓,必须穿透API层面,深入源码理解其底层逻辑。

本文将以“启动流程→线程模型→事件传播→数据读写”为主线,结合源码、注释、时序图和场景分析,全面解析Netty 4.1.x的核心实现。我们会回答这些关键问题:

- Netty的主从Reactor模型如何通过源码落地?

- EventLoop如何实现“单线程处理多Channel”且保证线程安全?

- ChannelPipeline的责任链模式如何高效传播事件?

- Netty如何修复JDK NIO的致命缺陷(如空轮询)?

- 一个客户端连接从建立到数据交互的全链路源码流程是怎样的?

一、ServerBootstrap启动流程:主从Reactor的初始化

Netty服务端的启动入口是

ServerBootstrap.bind(),这一过程完成了主从Reactor(BossGroup/WorkerGroup)的初始化、ServerSocketChannel的创建与注册、端口绑定等核心操作。我们从源码角度拆解这一流程。1.1 ServerBootstrap的初始化与配置

在HelloWorld中,服务端启动代码如下:

这部分代码的核心是

ServerBootstrap的配置与bind方法。我们先看ServerBootstrap的类结构:ServerBootstrap继承自AbstractBootstrap,父类负责管理主Reactor(BossGroup)和服务端Channel(如NioServerSocketChannel)的配置;自身则管理从Reactor(WorkerGroup)和客户端Channel(如NioSocketChannel)的配置(childOption、childHandler等)。这种分层设计使得服务端和客户端Channel的配置相互隔离,逻辑清晰。1.2 bind()方法:从配置到端口绑定的全流程

bind()是启动的核心方法,其底层调用链路为:ServerBootstrap.bind(int port) → AbstractBootstrap.bind(SocketAddress localAddress) → doBind(SocketAddress localAddress)我们重点解析

doBind方法(源码简化后):doBind的核心是两步:初始化并注册Channel(initAndRegister)、绑定端口(doBind0)。这两步通过Future-Listener机制实现异步协调,确保注册完成后再执行绑定,避免操作顺序错误。1.2.1 initAndRegister:Channel的创建与注册

initAndRegister负责创建服务端Channel(如NioServerSocketChannel)并将其注册到BossGroup的EventLoop中:- 步骤1:创建Channel

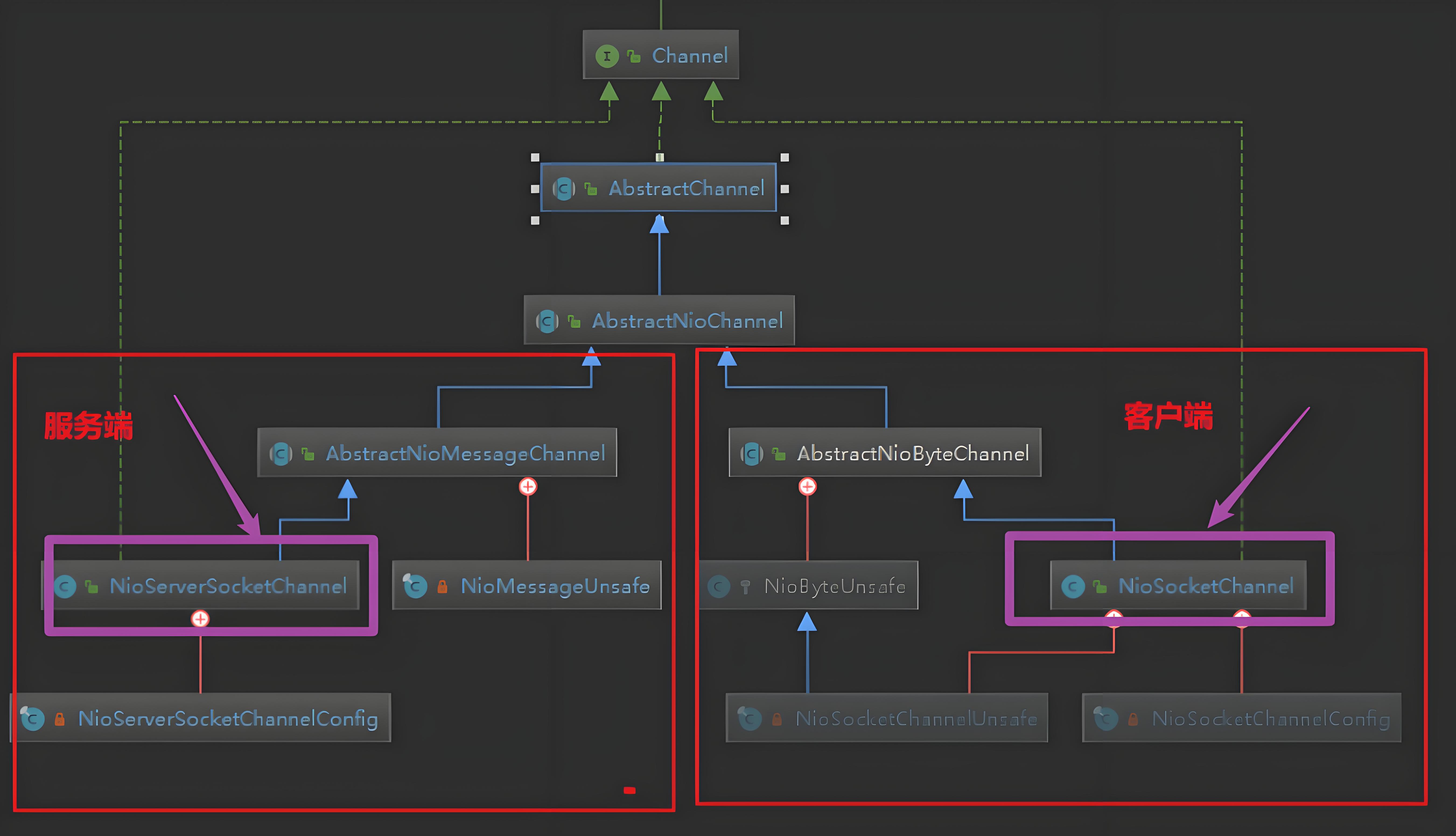

channelFactory.newChannel()通过反射创建NioServerSocketChannel,其构造函数如下:可见,

NioServerSocketChannel是对JDK ServerSocketChannel的封装,其核心是持有底层NIO通道,并通过父类AbstractNioChannel初始化关注的事件(OP_ACCEPT)。这种封装隔离了JDK NIO的底层细节,为上层提供统一的Channel接口。- 步骤2:初始化Channel(init方法)

init(channel)是ServerBootstrap的核心方法,负责配置服务端Channel并设置客户端Channel的处理器:初始化过程的核心是配置服务端Channel的选项、属性,并添加

ServerBootstrapAcceptor。ServerBootstrapAcceptor作为连接主从Reactor的桥梁,其添加过程通过ch.eventLoop().execute()确保在Channel绑定的EventLoop线程中执行,遵循Netty的线程安全原则。- 步骤3:注册Channel到EventLoop

config().group().register(channel)最终调用AbstractChannel.AbstractUnsafe.register(Unsafe是Netty内部用于操作底层IO的接口,封装了不安全的底层操作,避免用户直接调用):注册的核心是将

NioServerSocketChannel对应的JDK ServerSocketChannel注册到BossGroup中某个EventLoop的Selector上,初始关注事件为0(后续绑定端口后会更新为OP_ACCEPT)。这一过程通过循环处理CancelledKeyException,确保注册成功,体现了Netty的健壮性。1.2.2 doBind0:端口绑定与监听

当Channel注册完成后,

doBind0负责调用JDK NIO的bind方法绑定端口:绑定成功后,

NioServerSocketChannel会触发ChannelActive事件,该事件传播到ChannelPipeline后,最终会调用NioServerSocketChannel的doBeginRead方法,将Selector关注的事件更新为OP_ACCEPT:至此,服务端启动完成,BossGroup的EventLoop开始监听OP_ACCEPT事件(客户端连接请求)。整个过程通过Outbound事件从Tail到Head的传播,最终调用到底层JDK方法,体现了责任链模式的灵活性。

1.3 启动流程时序图(mermaid格式)

二、EventLoop与EventLoopGroup:Netty的线程模型核心

EventLoop是Netty的线程模型核心,负责处理Channel的所有IO事件和任务。理解EventLoop的工作机制是掌握Netty并发模型的关键。

2.1 EventLoopGroup的结构与初始化

EventLoopGroup是EventLoop的容器,NioEventLoopGroup是其NIO实现,用于管理NIO类型的EventLoop。NioEventLoopGroup的构造函数最终调用:- 线程数默认值:

DEFAULT_EVENT_LOOP_THREADS = Math.max(1, SystemPropertyUtil.getInt("io.netty.eventLoopThreads", Runtime.getRuntime().availableProcessors() * 2)),即CPU核心数*2。这一默认值平衡了IO密集型任务的并发需求,减少线程上下文切换。

- newChild方法:创建

NioEventLoop,每个NioEventLoop对应一个线程和一个Selector:

2.2 NioEventLoop的结构与核心方法

NioEventLoop是EventLoop的NIO实现,其核心属性包括:Selector selector:JDK NIO的Selector,用于监听IO事件。

Thread thread:绑定的线程,一个NioEventLoop对应一个线程,且终身绑定。

Queue<Runnable> taskQueue:普通任务队列,存储execute()提交的任务。

PriorityQueue<ScheduledFutureTask<?>> scheduledTaskQueue:定时任务队列,存储schedule()提交的任务。

volatile boolean wakenUp:用于唤醒Selector的标志,避免select()阻塞。

SelectStrategy selectStrategy:选择策略,决定是否进行select或处理任务。

2.2.1 NioEventLoop的run方法:事件循环的核心

NioEventLoop的run方法是线程的主循环,负责处理IO事件和任务,其核心逻辑可分为三步:select(监听IO事件)、processSelectedKeys(处理就绪事件)、runAllTasks(执行任务)。源码简化后:

这一循环体现了Netty的事件驱动模型:线程不断在“等待IO事件→处理事件→执行任务”之间循环,高效利用CPU。

- 步骤1:select(监听IO事件)

select方法负责阻塞等待IO事件,同时处理唤醒和超时:这段代码是Netty解决JDK NIO空轮询bug的核心:JDK的Selector可能在没有事件时唤醒(空轮询),导致线程空转,CPU占用100%。Netty通过统计连续空轮询次数,当超过

SELECTOR_AUTO_REBUILD_THRESHOLD(默认512)时,调用rebuildSelector重建Selector,彻底解决该问题。此外,

select方法通过wakenUp标志协调IO事件和任务:当有任务需要执行时,唤醒Selector避免阻塞,确保任务及时处理。- 步骤2:processSelectedKeys(处理就绪事件)

当Selector监听到就绪事件后,

processSelectedKeys负责分发事件(如OP_ACCEPT、OP_READ):值得注意的是,Netty通过

SelectedSelectionKeySet优化了JDK的selectedKeys(从HashSet改为数组),减少迭代开销,提升事件处理效率。这一细节体现了Netty对性能的极致追求。- 步骤3:runAllTasks(执行任务)

runAllTasks负责执行任务队列中的普通任务和定时任务,保证业务逻辑能在EventLoop线程中执行(避免线程安全问题):任务执行过程中,每64个任务检查一次超时,避免任务执行时间过长阻塞IO事件处理。这种“批次执行+超时控制”的策略,平衡了任务处理和IO响应的及时性。

2.3 任务队列的细节

Netty的任务队列设计是保证线程模型高效运行的关键,以下是核心细节:

- 任务类型:

- 普通任务:通过

eventLoop.execute(Runnable)提交,如用户自定义业务逻辑。 - 定时任务:通过

eventLoop.schedule(Runnable, delay, unit)提交,如定时心跳检测。 - 尾部任务:通过

executeAfterEventLoopIteration(Runnable)提交,在每次事件循环迭代后执行,如统计信息收集。

- 任务队列实现:

- 普通任务队列默认使用

MpscQueue(多生产者单消费者队列),支持多线程并发提交,单线程消费,无锁高效。 - 定时任务队列使用

PriorityQueue,按到期时间排序,确保按时执行。

- 任务提交与执行:

- 外部线程提交任务时,通过

MpscQueue的offer方法非阻塞入队。 - EventLoop线程在

runAllTasks中出队并执行,确保所有任务在单线程中运行,避免线程安全问题。

- 任务优先级:

- IO事件处理优先于任务执行?不,Netty通过

select方法中的wakenUp机制,确保有任务时唤醒Selector,优先执行任务,避免任务饥饿。 - 定时任务到期后会被移到普通任务队列,与普通任务按提交顺序执行。

2.4 EventLoop与Channel的绑定关系

Netty的核心设计之一是:一个Channel终身绑定一个EventLoop,一个EventLoop可以处理多个Channel。这种绑定保证了:

- 线程安全:所有IO事件和任务都在同一个线程(EventLoop的线程)中处理,

ChannelHandler无需加锁,简化开发。

- 性能优化:减少线程上下文切换,避免缓存失效(Channel相关数据在EventLoop线程的缓存中)。

- 操作有序性:事件和任务按提交顺序执行,避免并发导致的逻辑混乱(如先写后读的操作不会乱序)。

绑定过程在

AbstractChannel.register中完成,一旦绑定,终身不变。EventLoop通过轮询方式选择Channel(DefaultEventExecutorChooserFactory的PowerOfTwoEventExecutorChooser),均衡负载。2.5 EventLoopGroup的线程模型配置

Netty通过配置

EventLoopGroup支持不同的Reactor模型:- 单Reactor单线程:

- 所有操作(连接处理、IO读写、任务执行)在单个线程中完成。

- 适用场景:低并发、轻量业务,如测试环境。

- 单Reactor多线程:

- 一个Reactor(多个线程)同时处理连接和IO,本质是多线程共享Selector。

- 适用场景:中等并发,连接数不多的场景。

- 主从Reactor(默认):

- BossGroup处理连接,WorkerGroup处理IO,职责分离。

- 适用场景:高并发、高吞吐量,如生产环境服务器。

Netty的灵活性使其能适应不同的业务场景,只需调整

EventLoopGroup的配置即可。2.6 EventLoop运行时序图

三、客户端连接处理:从OP_ACCEPT到注册到WorkerGroup

当客户端发起连接请求时,BossGroup的EventLoop会监听到OP_ACCEPT事件,触发连接处理流程,最终将新创建的

NioSocketChannel注册到WorkerGroup的EventLoop中。3.1 OP_ACCEPT事件的处理

BossGroup的EventLoop在

processSelectedKey中处理OP_ACCEPT事件时,会调用NioServerSocketChannel的unsafe.read(),其底层实现为:NioServerSocketChannel通过JDK的accept()获取客户端的SocketChannel,并封装为NioSocketChannel。accept()可能一次性返回多个连接(尤其是高并发场景),因此通过循环处理,直到没有更多连接或达到限制。3.2 ServerBootstrapAcceptor:连接主从Reactor的桥梁

ServerBootstrapAcceptor是NioServerSocketChannel的ChannelPipeline中的一个InboundHandler,负责将新创建的NioSocketChannel注册到WorkerGroup:ServerBootstrapAcceptor的作用是连接主Reactor(BossGroup)和从Reactor(WorkerGroup),其核心逻辑包括:- 配置客户端Channel的选项(如

SO_KEEPALIVE)和属性。

- 添加用户自定义的

ChannelHandler(通过childHandler,通常是ChannelInitializer)。

- 将客户端Channel注册到WorkerGroup,完成从“连接接收”到“业务处理”的移交。

注册过程通过

childGroup.register(child)实现,WorkerGroup会选择一个EventLoop(轮询策略)绑定该Channel,此后该Channel的所有操作都在该EventLoop中执行。3.3 客户端Channel的注册与激活

childGroup.register(child)的流程与服务端Channel的注册类似,最终将NioSocketChannel注册到WorkerGroup的EventLoop的Selector上,并关注OP_READ事件(读取数据):- 注册:调用

AbstractChannel.register,绑定EventLoop,注册到Selector(初始关注0事件)。

- 触发事件:注册成功后触发

ChannelRegistered事件。

- 激活:

NioSocketChannel在注册后处于活跃状态(连接已建立),触发ChannelActive事件。

- 开始读取:

ChannelActive事件传播后,调用doBeginRead,将Selector关注的事件更新为OP_READ。

至此,客户端Channel完成初始化,开始监听数据读取事件。

3.4 WorkerGroup选择EventLoop的策略

WorkerGroup通过

EventExecutorChooser选择EventLoop,默认使用PowerOfTwoEventExecutorChooser(适用于线程数为2的幂):轮询策略确保Channel均匀分布在WorkerGroup的EventLoop中,平衡负载,避免某一线程过载。

3.5 客户端连接处理时序图

四、ChannelPipeline与ChannelHandler:事件传播机制

ChannelPipeline是ChannelHandler的容器,采用责任链模式管理事件的传播。理解事件传播机制是编写ChannelHandler的基础。4.1 ChannelPipeline的结构

每个

Channel在创建时会初始化一个DefaultChannelPipeline,其构造函数如下:DefaultChannelPipeline内部维护一个双向链表,包含:- HeadContext:链表头,既是

ChannelInboundHandler又是ChannelOutboundHandler,负责与底层IO交互(如触发channelActive、执行bind等)。

- TailContext:链表尾,既是

ChannelInboundHandler又是ChannelOutboundHandler,负责处理未被其他Handler处理的事件(如释放未处理的消息)。

- 中间节点:用户自定义的

ChannelHandler,按添加顺序插入链表。

结构示意图:

4.2 ChannelHandlerContext的作用

ChannelHandlerContext是ChannelHandler与ChannelPipeline之间的桥梁,每个ChannelHandler对应一个ChannelHandlerContext,封装了Handler的上下文信息:- 关联的

Channel和ChannelPipeline。

- 链表中的前驱(

prev)和后继(next)节点。

- 事件传播方法(如

fireChannelRead、write)。

通过

ChannelHandlerContext,Handler可以:- 传播事件到下一个Handler(

ctx.fireChannelRead(msg))。

- 执行IO操作(

ctx.writeAndFlush(msg))。

- 获取相关组件(

ctx.channel()、ctx.pipeline())。

ChannelHandlerContext的设计隔离了Handler与Pipeline的直接交互,使责任链模式更灵活。4.3 Inbound事件的传播

Inbound事件是指由底层IO触发的事件(如连接建立、数据读取、异常等),传播方向是从Head到Tail。常见的Inbound事件包括:

channelRegistered:Channel注册到EventLoop。

channelActive:Channel激活(连接建立)。

channelRead:读取到数据。

channelReadComplete:数据读取完成。

exceptionCaught:发生异常。

以

channelRead事件(读取到数据)为例,传播流程如下:NioSocketChannel的unsafe.read()读取数据后,调用pipeline.fireChannelRead(msg):

AbstractChannelHandlerContext.invokeChannelRead调用Head节点的channelRead方法:

- Head节点的

channelRead方法(HeadContext实现):

- 事件依次传播,经过用户自定义的

HelloHandler的channelRead:

- 若所有InboundHandler都处理完成,事件最终到达

TailContext:

TailContext会释放未被处理的消息,这是Netty防止内存泄漏的重要机制,因此用户Handler应尽量调用ctx.fireChannelRead(msg)传递消息,或手动释放(ReferenceCountUtil.release(msg))。4.4 Outbound事件的传播

Outbound事件是指由用户主动发起的操作(如绑定、连接、写入数据等),传播方向是从Tail到Head。常见的Outbound事件包括:

bind:绑定端口。

connect:连接远程服务器。

write:写入数据(不刷新)。

flush:刷新数据(发送到网络)。

close:关闭Channel。

以

writeAndFlush(写入并刷新数据)为例,传播流程如下:- 用户调用

ctx.writeAndFlush(msg),实际调用DefaultChannelPipeline的writeAndFlush:

TailContext的writeAndFlush方法:

- 事件沿链表向Head传播,经过用户自定义的OutboundHandler(如

MessageToByteEncoder):

- 最终到达

HeadContext,调用底层IO操作:

Outbound事件的传播体现了Netty的分层设计:用户只需关注业务逻辑(如发送消息),底层IO操作由框架处理,简化开发。

4.5 事件传播的线程安全性

Netty保证所有事件的传播和

ChannelHandler的方法调用都在Channel绑定的EventLoop线程中执行,因此:ChannelHandler无需考虑线程安全(无需加锁)。

- 避免了多线程并发导致的竞态条件(如同时读写数据)。

- 事件和任务按顺序执行,逻辑清晰。

这一设计极大简化了

ChannelHandler的实现,是Netty易用性的重要保障。4.6 责任链模式的优势

ChannelPipeline的责任链模式具有以下优势:- 解耦:每个

ChannelHandler专注于单一职责(如编码、日志、业务处理),模块间低耦合。

- 灵活:通过添加/移除Handler,可动态调整事件处理流程(如动态开启/关闭日志)。

- 可扩展:用户可自定义Handler扩展功能,无需修改框架核心代码。

例如,一个典型的服务端Pipeline可能包含:

LoggingHandler:打印日志。

LengthFieldBasedFrameDecoder:处理粘包/拆包。

StringDecoder:将ByteBuf转为String。

BusinessHandler:处理业务逻辑。

4.7 事件传播时序图(Inbound与Outbound)

五、数据读写流程:从客户端发送到服务端处理

结合HelloWorld案例,我们详细解析客户端发送数据到服务端处理的全流程。

5.1 客户端发送数据(writeAndFlush)

客户端

ClientHelloHandler在channelActive中发送数据:发送流程如下:

ctx.writeAndFlush(buf)触发Outbound事件,从Tail向Head传播。

- 经过Pipeline中的OutboundHandler(若有),最终到达Head。

HeadContext调用unsafe.write,将数据添加到ChannelOutboundBuffer。

flush操作将ChannelOutboundBuffer中的数据写入JDKSocketChannel:

若写入缓冲区满,Netty会注册OP_WRITE事件,待通道可写时继续写入,避免阻塞。

5.2 服务端读取数据(OP_READ事件)

服务端

NioSocketChannel的EventLoop监听到OP_READ事件后,调用unsafe.read()读取数据:读取流程的核心是:

- 动态分配缓冲区(根据接收缓冲区大小和实际数据量)。

- 调用JDK的`SocketChannel的read方法,将数据写入ByteBuf。

- 触发

channelRead事件,将数据传入Pipeline。

- 循环读取,直到没有更多数据或达到读取限制。

5.3 服务端数据处理与响应

服务端

ChannelPipeline接收到channelRead事件后,数据沿InboundHandler链传播,最终到达用户自定义的HelloHandler:5.3.1 粘包/拆包处理(以LengthFieldBasedFrameDecoder为例)

在实际场景中,TCP传输可能出现粘包/拆包,Netty通过

LengthFieldBasedFrameDecoder解决这一问题。假设客户端发送的数据格式为“长度+内容”(前4字节为长度),服务端Pipeline配置如下:LengthFieldBasedFrameDecoder:根据长度字段截取完整消息,解决粘包/拆包。

StringDecoder:将ByteBuf转为String,简化业务处理。

此时

HelloHandler的channelRead方法接收的msg直接为解析后的字符串,无需手动处理字节转码:5.3.2 响应发送流程

HelloHandler处理完数据后,调用ctx.writeAndFlush(responseBuf)发送响应,该过程是Outbound事件传播的典型案例:- 响应数据封装:业务数据(如“hello client!”)被封装为

ByteBuf。

- Outbound事件传播:事件从

Tail向Head传播,经过可能的OutboundHandler(如编码器)。

- 编码处理:若存在

StringEncoder,会将字符串转为ByteBuf(与服务端解码对应)。

- 底层写入:

HeadContext调用unsafe.write,将数据写入JDKSocketChannel:

- 刷新操作:

flush触发缓冲区数据实际发送到网络,确保数据不滞留。

5.4 客户端接收响应

客户端

NioSocketChannel监听到OP_READ事件后,读取服务端响应数据,流程与服务端读取类似:- 读取响应:

unsafe.read()读取数据到ByteBuf,触发channelRead事件。

- 解码处理:客户端

ChannelPipeline中的StringDecoder将ByteBuf转为字符串。

- 业务处理:

ClientHelloHandler接收字符串并打印:

- 连接关闭:

ctx.close()触发Outbound事件,最终调用SocketChannel.close()关闭连接。

当服务端业务逻辑处理完客户端请求后,会通过ChannelHandlerContext.writeAndFlush()方法发送响应。这个过程涉及Outbound事件的传播、数据编码和底层网络操作,是Netty性能优化的关键环节。

5.4.1 响应数据的封装与发送

服务端

HelloHandler在处理完请求后,会构造响应并发送:5.4.2 Outbound事件传播机制

ctx.writeAndFlush()触发的Outbound事件会从当前Handler开始,逆序遍历Pipeline中的OutboundHandler:- 事件触发:

ctx.writeAndFlush()从当前Handler(如HelloHandler)开始向上游传播。

- 编码器处理:如果存在编码器(如

StringEncoder),会将String转为ByteBuf。

- 内存分配:若需要,通过

ByteBufAllocator分配堆外内存。

- 数据写入:最终由

HeadContext调用unsafe.write()将数据写入底层SocketChannel。

5.4.3 底层写入与刷新机制

Netty将写入操作分为两个阶段:

- write阶段:将数据放入

ChannelOutboundBuffer缓冲区,不立即发送。

- flush阶段:将缓冲区数据真正写入Socket,并清空缓冲区。

5.4.4 零拷贝与批量操作优化

Netty通过以下机制提升响应性能:

- CompositeByteBuf:合并多个ByteBuf,减少内存拷贝。

- FileRegion:通过

transferTo()实现文件传输零拷贝。

- 批量操作:

ChannelOutboundBuffer支持批量写入,减少系统调用次数。

5.5 数据读写全链路时序图

六、Reactor模型场景分析与Netty适配

Reactor模式是Netty线程模型的基础,Netty通过灵活配置支持多种Reactor变体,适应不同业务场景。

6.1 单Reactor单线程模型

模型结构:

- 一个Reactor(单线程)同时负责“监听连接(OP_ACCEPT)”和“处理IO事件(OP_READ/OP_WRITE)”。

- 所有事件和任务在单个线程中执行。

Netty配置:

适用场景:

- 低并发、短连接场景(如简单测试服务)。

- 无耗时任务的业务(避免阻塞唯一线程)。

局限性:

- 单线程瓶颈明显,无法利用多核CPU。

- 任一操作阻塞会导致整个服务瘫痪(如耗时业务逻辑)。

6.2 单Reactor多线程模型

模型结构:

- 一个Reactor线程负责监听连接(OP_ACCEPT)。

- 多个工作线程处理IO事件和任务(共享一个EventLoopGroup)。

Netty配置:

适用场景:

- 中等并发场景,连接数适中(1000-10000)。

- IO密集型业务(如简单数据转发)。

优势:

- 分离连接监听和IO处理,利用多核CPU。

- 避免单线程瓶颈,提高并发处理能力。

局限性:

- 单个Boss线程仍可能成为高并发连接的瓶颈。

6.3 主从Reactor模型(Netty默认推荐)

模型结构:

- 主Reactor(BossGroup):多个线程监听连接(OP_ACCEPT),分散连接压力。

- 从Reactor(WorkerGroup):多个线程处理IO事件和任务,独立负责已连接Channel。

Netty配置:

适用场景:

- 高并发、高吞吐量场景(如分布式服务、网关)。

- 长连接业务(如IM、游戏服务器)。

优势:

- 主Reactor多线程分担连接压力,支持海量连接。

- 从Reactor隔离不同Channel的IO处理,避免相互影响。

- 充分利用多核CPU,性能最优。

6.4 不同模型的性能对比

模型 | 并发能力 | 资源占用 | 适用场景 | 瓶颈点 |

单Reactor单线程 | 极低 | 低 | 测试、轻量服务 | 单线程 |

单Reactor多线程 | 中等 | 中 | 中等并发、IO密集型 | Boss线程、Worker负载 |

主从Reactor | 极高 | 高 | 高并发、高吞吐量、长连接 | 网络带宽、CPU核心数 |

Netty通过

EventLoopGroup的线程数配置,可灵活切换模型,满足不同业务需求。生产环境中,主从Reactor是最优选择,BossGroup线程数通常为CPU核心数,WorkerGroup为CPU核心数*2。七、任务队列深度解析:事件与任务的协同

Netty的任务队列是线程模型的“神经中枢”,负责协调IO事件与业务任务的执行,其设计直接影响性能和稳定性。

7.1 任务队列的类型与实现

Netty任务队列分为三类,均通过

EventLoop提供API操作:- 普通任务队列(TaskQueue)

- API:

eventLoop.execute(Runnable task) - 实现:默认使用

MpscQueue(多生产者单消费者队列),线程安全且无锁。 - 特性:先进先出(FIFO),支持多线程并发提交,单线程(EventLoop)消费。

- 场景:非定时业务逻辑(如数据库查询、消息转发)。

- 定时任务队列(ScheduledTaskQueue)

- API:

eventLoop.schedule(Runnable task, long delay, TimeUnit unit) - 实现:

PriorityQueue,按任务到期时间排序。 - 特性:定时执行,到期后移至普通任务队列。

- 场景:心跳检测、超时重试(如3秒后重试连接)。

- 尾部任务队列(TailTaskQueue)

- API:

eventLoop.executeAfterEventLoopIteration(Runnable task) - 实现:普通队列,在每次事件循环迭代后执行。

- 特性:优先级低于IO事件和普通任务,用于轻量统计(如QPS计算)。

7.2 任务提交与执行机制

7.2.1 外部线程提交任务

当业务线程(非EventLoop线程)提交任务时,流程如下:

- 入队:任务通过

MpscQueue.offer()非阻塞入队,支持高并发提交。

- 唤醒EventLoop:若EventLoop正在

select阻塞,通过wakenUp.set(true)和selector.wakeup()唤醒,确保任务及时执行。

7.2.2 EventLoop线程内执行任务

EventLoop在

runAllTasks()中处理任务:- 任务优先级:IO事件与任务执行通过

select中的wakenUp机制动态平衡,避免任务饥饿。

- 超时控制:限制单次任务执行总时间,防止任务阻塞IO事件处理。

7.3 任务队列的线程安全保障

- 单线程执行:所有任务在EventLoop线程中执行,无需加锁(如

ChannelHandler中的任务)。

- 内存可见性:

MpscQueue通过volatile和内存屏障保证任务提交的可见性。

- 有序性:任务按提交顺序执行,避免并发导致的逻辑混乱(如先写后读的操作不会乱序)。

7.4 任务队列的最佳实践

- 避免长时间任务:任务执行时间应控制在毫秒级,否则会阻塞IO事件(如复杂计算应异步处理)。

- 定时任务轻量化:定时任务应避免频繁执行(如100ms一次),防止占用过多CPU。

- 利用任务队列实现线程切换:通过

eventLoop.execute()将非EventLoop线程的操作切换到EventLoop线程,保证线程安全。

7.5 任务队列在数据处理中的深度应用

Netty的任务队列不仅用于线程间通信,还在数据处理流程中扮演关键角色,特别是在异步化、解耦和流量控制方面。

7.5.1 异步数据处理模式

对于耗时的数据处理任务(如数据库查询、远程调用),可通过任务队列将其从EventLoop线程中剥离,避免阻塞IO操作:

7.5.2 流量控制与任务调度

任务队列可配合水位线(High/Low Watermark)实现流量控制:

7.5.3 定时任务在心跳检测中的应用

Netty的定时任务队列常用于实现心跳机制:

八、Netty设计思想在业务开发中的应用

Netty的源码不仅是高性能网络框架的实现,更蕴含丰富的设计思想,可直接借鉴到业务开发中。

8.1 责任链模式(ChannelPipeline)的业务应用

ChannelPipeline的责任链模式可用于流程化业务场景,如接口请求处理:优势:

- 流程模块化,各Handler专注单一职责(日志、权限、业务)。

- 可动态增减Handler(如临时关闭日志),灵活扩展。

8.2 事件驱动模型(EventLoop)的异步处理

Netty的事件驱动模型可用于异步业务场景,如订单状态变更通知:

优势:

- 事件发布者与订阅者解耦,新增通知方无需修改发布逻辑。

- 单线程执行事件,避免并发问题(如订单状态一致性)。

8.3 线程模型(EventLoop绑定)的并发控制

Netty的“Channel绑定EventLoop”思想可用于并发资源控制,如数据库连接池:

优势:

- 每个连接绑定专属线程,避免多线程竞争连接导致的锁开销。

- 所有操作在单线程执行,无需考虑JDBC连接的线程安全问题。

8.4 异常处理机制的借鉴

Netty的异常传播机制(

exceptionCaught)可用于统一异常处理:优势:

- 集中处理异常,避免代码中大量

try-catch。

- 统一异常响应格式,便于前端处理。

九、Netty源码中的性能优化细节

Netty的高性能不仅源于架构设计,更依赖大量细节优化,以下是关键优化点:

9.1 JDK NIO缺陷修复

- 空轮询修复:通过

SELECTOR_AUTO_REBUILD_THRESHOLD监测连续空轮询,超过阈值时重建Selector,避免CPU 100%。

- SelectedKeys优化:替换JDK

Selector的HashSet为SelectedSelectionKeySet(数组实现),减少迭代开销,提升事件处理效率。

- SelectionKey管理:通过

AbstractNioChannel维护selectionKey,避免频繁创建和销毁,减少GC。

9.2 内存管理优化

- ByteBuf内存池:Netty的

PooledByteBufAllocator通过内存池复用ByteBuf,减少堆外内存分配/释放的系统调用开销,降低GC频率。

- 零拷贝机制:

CompositeByteBuf:合并多个ByteBuf而不复制数据。FileRegion:通过transferTo实现文件传输零拷贝,避免用户态到内核态的数据拷贝。

- 内存释放机制:

TailContext自动释放未处理的ByteBuf,配合ReferenceCountUtil,防止内存泄漏。

9.3 线程模型优化

- 线程绑定:

Channel与EventLoop终身绑定,减少线程上下文切换和缓存失效。

- 任务队列优化:

MpscQueue的无锁设计,支持高效的多生产者单消费者模型。

- IO与任务协同:

wakenUp标志协调IO事件和任务执行,避免任务饥饿或IO阻塞。

结语

本文从Netty启动流程、线程模型、事件传播、数据读写等核心环节深入源码,解析了主从Reactor的实现、EventLoop的事件循环、ChannelPipeline的责任链等关键机制,并结合场景分析了不同Reactor模型的适用场景。

Netty的精髓在于:用分治思想拆分复杂问题(主从Reactor)、用事件驱动协调异步操作(EventLoop)、用责任链模式解耦处理流程(ChannelPipeline)、用线程绑定保证安全与性能(EventLoop-Channel绑定)。

通过深入分析Netty源码,我们可以总结出以下高性能网络编程的最佳实践:

- 线程模型优化

- 高并发场景使用主从Reactor模型,Boss线程数为CPU核心数,Worker线程数为CPU核心数*2。

- 避免在EventLoop线程中执行耗时操作,将业务逻辑放入独立线程池。

- 内存管理

- 优先使用

PooledByteBufAllocator,减少内存分配开销。 - 及时释放

ByteBuf资源,避免内存泄漏。 - 使用

CompositeByteBuf和FileRegion实现零拷贝。

- 责任链设计

- 将业务逻辑拆分为独立Handler,保持单一职责。

- 使用

ChannelPipeline动态编排处理流程。

- 异步编程

- 通过

Future/Promise模型处理异步操作,避免阻塞。 - 使用

EventLoop.execute()将任务提交到正确线程执行。

- 流量控制

- 配置合理的水位线,防止内存溢出。

- 使用

ChannelOption参数优化TCP连接(如TCP_NODELAY、SO_KEEPALIVE)。

- 异常处理

- 在Pipeline末尾添加

ExceptionHandler统一处理异常。 - 避免在Handler中吞掉异常,确保异常能被正确捕获和记录。

掌握Netty源码不仅能帮助我们更好地使用框架,更能学习到优秀的架构设计思想和性能优化技巧,这些知识对构建高性能、高并发的分布式系统至关重要。

这些设计思想不仅适用于网络编程,更可广泛应用于业务系统开发,如责任链模式处理接口请求、事件驱动实现解耦通知、线程模型控制并发等。

深入Netty源码,不仅是为了更好地使用框架,更是为了学习优秀的设计理念,提升架构设计能力。建议结合实际场景调试源码,感受其设计之美与细节之精。